TCP连接 网络异常 为何会出现过多的 close wait 状态?

- 问答

- 2025-08-21 12:54:39

- 13

🚨 震惊!你的服务器可能正在被“僵尸连接”拖垮

2025年8月10日,某云服务商披露了一起因TCP CLOSE_WAIT状态堆积导致的服务瘫痪事件——某电商大促期间,订单系统因未正确关闭数据库连接,引发数万CLOSE_WAIT连接堆积,最终触发“Too many open files”错误,服务中断长达3小时,这究竟是技术债的必然爆发,还是开发者的疏忽?本文带你揭秘这一网络幽灵的真相!

📡 TCP连接的“分手仪式”:四次挥手全解析

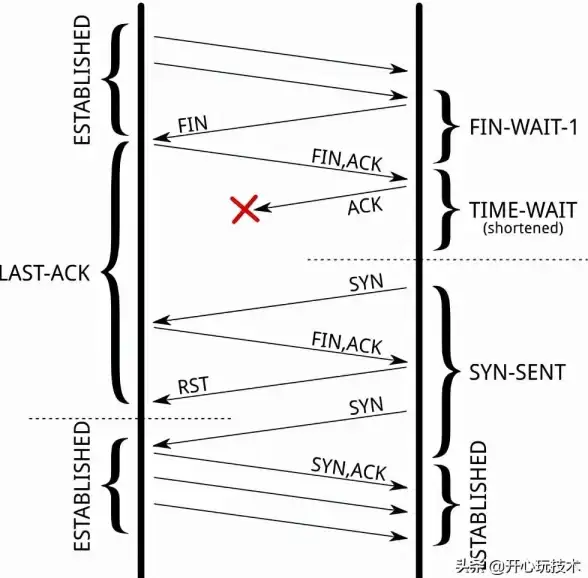

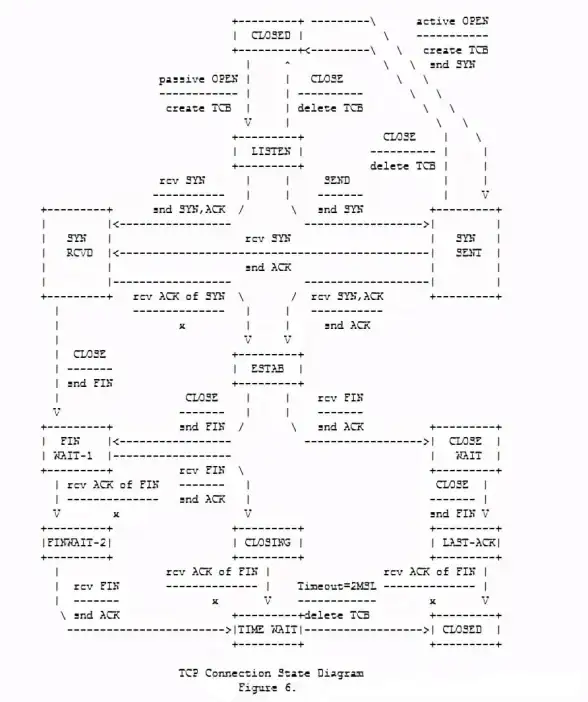

TCP连接的关闭如同一场精心设计的分手仪式,需经历四次挥手:

1️⃣ 客户端说再见:发送FIN包,进入FIN_WAIT1状态

2️⃣ 服务器收信:回复ACK,客户端转为FIN_WAIT2

3️⃣ 服务器断后:发送FIN包,进入LAST_ACK状态

4️⃣ 客户端确认:回复ACK后进入TIME_WAIT,等待2MSL后彻底释放

关键角色:CLOSE_WAIT

当服务器收到客户端的FIN包并回复ACK后,会进入CLOSE_WAIT状态,此时服务器需完成数据收尾并发送自己的FIN包,才能推进流程。若服务器未及时调用close()方法,连接将永远卡在此状态,如同分手后一方迟迟不搬走行李。

😱 CLOSE_WAIT过多的五大致命原因

1️⃣ 代码健忘症:忘记说再见

// 反面教材:未在finally块关闭连接!

try {

Socket socket = new Socket("db.example.com", 3306);

// 业务逻辑...

} catch (IOException e) {

log.error("连接失败");

} // 漏了socket.close()!

后果:连接池耗尽、文件描述符爆表,最终触发“Too many open files”崩溃。

2️⃣ 连接池管理灾难

某金融系统曾因连接池键值设计缺陷,使用下线服务的IP+端口作为连接标识,导致:

// 错误示例:连接池用IP+端口作为键 connPool.Alloc(downServiceIP, port) // 永远无法释放!

解决方案:引入心跳检测+超时机制,定期清理无效连接。

3️⃣ 异常处理缺位

未捕获的异常可能导致连接关闭逻辑跳过:

try:

conn.send(data)

except BrokenPipeError:

pass # 未调用conn.close()!

4️⃣ 防火墙/安全组干扰

某些防火墙可能误判FIN包为攻击,导致被动方无法发送FIN,连接卡在CLOSE_WAIT。

5️⃣ 操作系统配置陷阱

# 查看文件描述符限制 ulimit -n # 默认1024,高并发场景需调至65535 cat /proc/sys/fs/file-max # 系统级限制

🔧 自救指南:五步消灭CLOSE_WAIT

1️⃣ 代码审查:给每个连接装上“定时炸弹”

// Java正确姿势:try-with-resources自动关闭

try (Socket socket = new Socket("api.example.com", 80)) {

// 业务逻辑...

} // 自动调用close()

2️⃣ 连接池健康检查

配置超时时间和探活机制:

# HikariCP配置示例 maximumPoolSize: 100 idleTimeout: 60000 # 1分钟未使用则回收 connectionTestQuery: SELECT 1 # 定期检测连接活性

3️⃣ 内核参数调优

# 加速CLOSE_WAIT回收(需root权限) sysctl -w net.ipv4.tcp_fin_timeout=30 # 默认60秒→30秒 sysctl -w net.ipv4.tcp_keepalive_time=120 # 2分钟检测一次心跳

4️⃣ SO_LINGER暴力模式(慎用)

强制跳过TIME_WAIT,直接发送RST:

struct linger sl = {1, 0}; // 0秒超时

setsockopt(sockfd, SOL_SOCKET, SO_LINGER, &sl, sizeof(sl));

⚠️ 风险:可能丢失未发送数据,仅适用于短连接场景。

5️⃣ 监控告警:给CLOSE_WAIT装上“警报器”

# 实时监控CLOSE_WAIT数量 watch -n1 "netstat -ant | grep CLOSE_WAIT | wc -l" # 超过1000条时触发告警

🌐 2025年最新趋势:CLOSE_WAIT的智能防御

1️⃣ eBPF技术:通过内核级钩子实时拦截异常连接

2️⃣ AI驱动预测:基于历史数据预测CLOSE_WAIT爆发,提前扩容

3️⃣ 服务网格优化:Istio等工具自动注入连接健康检查逻辑

CLOSE_WAIT如同网络世界中的“分手后遗症”,看似是协议设计的副作用,实则暴露了代码健壮性的缺失,2025年的今天,通过智能监控、连接池优化和内核调优,我们已能将这一“幽灵状态”控制在安全范围内。优雅的结束,才是可靠连接的终极浪漫 💔→🚪!

本文由 业务大全 于2025-08-21发表在【云服务器提供商】,文中图片由(业务大全)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://xdh.7tqx.com/wenda/684555.html

发表评论